新智元报道

在这个科技飞速发展却又充满瓶颈的时代,检索增强技术在代码及多模态场景中的重要性愈发凸显,而现有的向量模型在代码和视觉模态检索方面却如此不给力,简直让人忍无可忍!但就在刚刚,智源研究院联合多所高校重磅出击,开放三款向量模型,犹如三把利刃,直接划破这沉闷的科技夜空!

检索增强技术在代码及多模态场景中那可是起着关键作用,向量模型更是检索增强体系里的核心。可当前的情况呢?相较于文本领域,现有向量模型在代码和视觉模态中的检索效果简直是惨不忍睹,这怎么能满足我们日益增长的科技需求?智源研究院显然无法容忍这种现状,他们联合多所高校日夜钻研,终于研发出了三款震撼业界的向量模型,分别是代码向量模型BGE - Code - v1,多模态向量模型BGE - VL - v1.5以及视觉化文档向量模型BGE - VL - Screenshot。

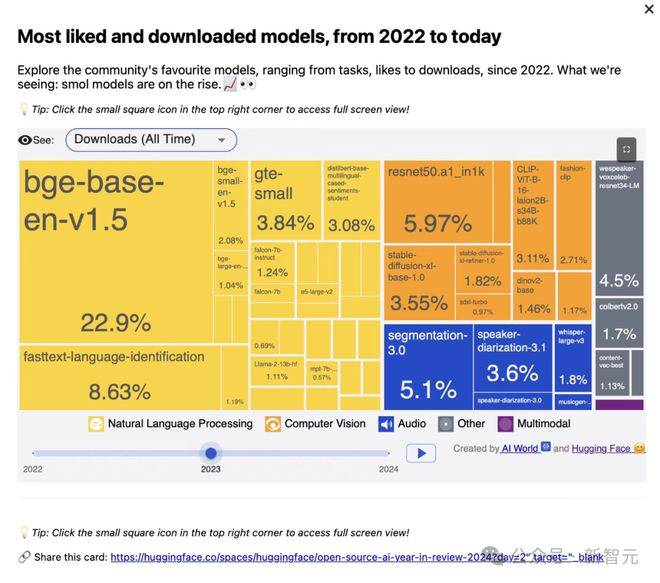

这些模型一登场,就如同咆哮的猛兽,在代码及多模态检索领域横冲直撞,取得了最佳效果,以压倒性的优势登顶CoIR、Code - RAG、MMEB、MVRB等领域内主要测试基准。BGE自2023年8月发布以来,就像一颗璀璨的新星,成为中国首个登顶Hugging Face榜首的国产AI模型,更是2023年所有发布模型的全球下载量冠军。而如今这三款新模型的发布,无疑是给BGE系列再添三把烈火!

目前,BGE - Code - v1、BGE - VL - v1.5、BGE - VL - Screenshot三款模型已向社区全面开放,这是对整个相关技术研究与产业应用的一次强力输血,为我们带来了无限的希望!

-

BGE - Code - v1:代码检索的超级战神

模型地址:https://huggingface.co/BAAI/bge - code - v1

项目主页:https://github.com/FlagOpen/FlagEmbedding/tree/master/research/BGE_Coder

论文链接:https://arxiv.org/abs/2505.12697

-

BGE - VL - v1.5:多模态检索的无敌王者

模型地址:https://huggingface.co/BAAI/BGE - VL - v1.5 - zs

项目主页:https://github.com/FlagOpen/FlagEmbedding/tree/master/research/BGE_VL

论文链接:https://arxiv.org/abs/2412.14475

-

BGE - VL - Screenshot:可视化文档检索的盖世英雄

模型地址:https://huggingface.co/BAAI/BGE - VL - Screenshot

项目主页:https://github.com/FlagOpen/FlagEmbedding/tree/master/research/BGE_VL_Screenshot

论文链接:https://arxiv.org/abs/2502.11431

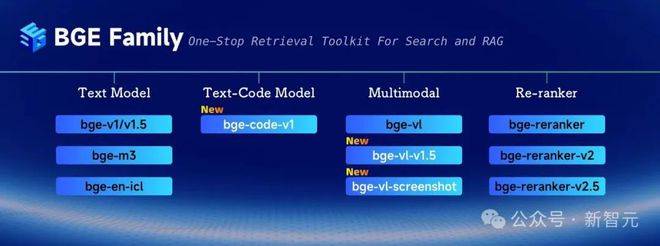

由智源研究院主导研发的通用向量模型系列BGE,一直致力于为各类数据提供高效一站式向量表征与语义检索方案。它就像一个不知疲倦的战士,不断推出覆盖中英文、多语言检索及重排模型等多个版本,持续刷新MTEB、C - MTEB、BEIR、MIRACL等主流文本向量评测基准。BGE凭借高性能与开源特性,受到业界的高度关注,已广泛应用于RAG、神经搜索等场景,累计下载超6亿次,被国内外多家AI企业集成,这是它实力的最好证明!

然而,检索增强技术正从传统的文本场景逐步拓展至涵盖代码与视觉等多模态数据的应用,现有向量模型却拖了后腿。但智源研究院没有丝毫退缩,他们带着满腔的怒火和决心,发布了这三款新模型,为构建更强大的多模态检索增强系统提供了坚实的支持!

BGE - Code - v1

新一代代码优化语义向量模型,冲破代码检索的枷锁

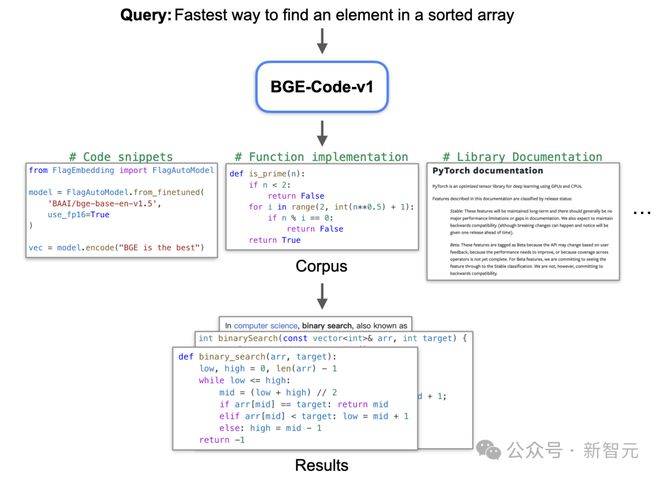

随着基础模型代码能力快速发展,Cursor、Copilot等辅助编程工具确实提升了生产力。但在面对百万行级代码库时,代码块检索增强需求就像一座大山压在我们头上,而检索模型的代码理解能力却如此薄弱,这让我们如何是好?BGE - Code - v1的出现,就是为了打破这个困境!

它是以Qwen2.5 - Coder - 1.5B为基座打造的新一代代码向量模型,专为各类代码检索相关任务而设计,同时还配备了强大的多语言文本理解能力。它就像一个精通多国语言的天才程序员,能在各种代码和文本之间自由穿梭。模型基于CoIR训练集和大量高质量代码 - 文本的合成数据进行训练,并使用课程学习,以BGE - gemma2 - multilingual的retrieval、STS数据为辅助,进一步提升代码与文本的理解能力。

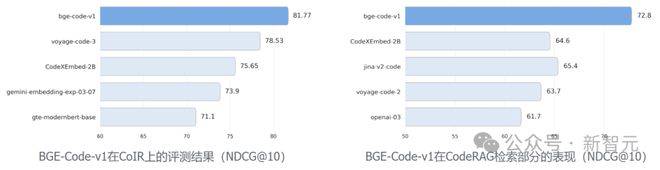

CoIR代码检索基准,收集了覆盖14种编程语言的4大类8个子任务,能够有效地评估模型在自然语言和代码的各类混合场景中的检索能力。CodeRAG - Bench基准评估了代码检索模型在代码检索增强(RACG)中的表现。而BGE - Code - v1在这两个基准上,就像一辆势不可挡的坦克,以显著优势超越谷歌、Voyage AI、Salesforce、Jina等商业/开源模型,登顶SOTA,让那些曾经在代码检索领域称王称霸的家伙们都黯然失色!

BGE - VL - v1.5

通用多模态检索模型,开启多模态检索新纪元

BGE - VL - v1.5是基于LLaVA - 1.6(7.57B参数)训练的新一代通用多模态检索模型,它就像一个经过千锤百炼的超级战士,全面升级了图文理解能力并具有更强大的检索能力。它在MagePairs 300万 (3M) 图文对齐数据基础上又收集了共100万条自然与合成数据(涵盖image - captioning数据、视觉问答数据、分类任务数据)进行多任务训练,显著地提升了模型在各类任务上的泛化性与理解能力。

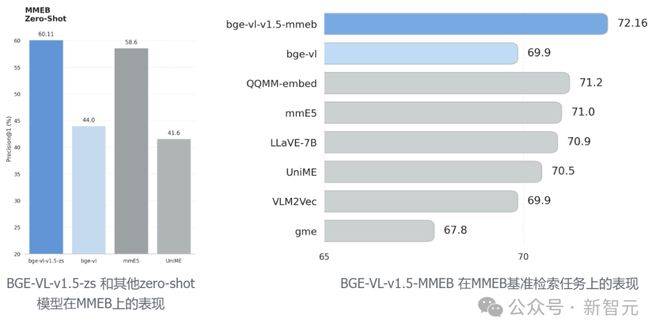

基于MegaPairs数据,BGE - VL - v1.5在多模态检索任务中就像一颗璀璨的流星,性能优势显著,不仅在图像检索中表现强劲,更在通用多模态场景中展现高适应性与准确率,适用于图文匹配、多模态问答、跨模态推荐等场景。MMEB是当前使用最广泛的多模态向量基准,由分类、视觉问答、检索、视觉基础知识四类任务构成。基于zero - shot设置(未使用MMEB训练集),BGE - VL - v1.5 - zs在MMEB基准中刷新zero - shot模型最佳表现;在检索任务上,基于MMEB微调的BGE - VL - v1.5 - MMEB以72.16分登顶SOTA,让其他多模态检索模型都望尘莫及!

BGE - VL - Screenshot

实用强大的视觉化文档向量模型,征服可视化信息检索难题

实际场景中网页、文档等多模态任务常由图文、符号、图表等多元素混合数据构成,这类任务称为「可视化信息检索」(Vis - IR)。可目前现有检索模型在这类任务中就像一个蹒跚学步的孩子,表现欠佳。BGE - VL - Screenshot模型的出现,就是为了拯救这个局面!

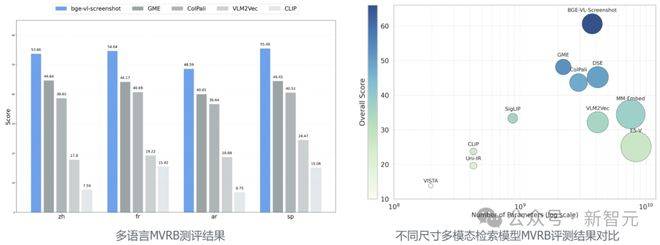

它基于Qwen2.5 - VL - 3B - Instruct,以新闻、商品、论文、文档、项目主页等七类数据源进行训练,收集超过1300万张截图和700万组标注截图问答样本。为了准确评估模型在Vis - IR任务上的表现,团队设计并推出了多模态检索基准MVRB (Massive Visualized IR Benchmark,涵盖截图检索、复合截图检索、截图QA和开放分类4项任务共20个数据集。BGE - VL - Screenshot在4项任务中就像一个战无不胜的将军,表现出色,以60.61的综合得分达到SOTA。在此基础上,通过少量query2screenshot多语言数据训练,模型实现了在英文之外的多语言任务上的出色表现。

智源研究院将继续带着满腔的热情和斗志,深耕向量模型与检索增强技术,进一步提升BGE模型系列的能力与通用性。未来,他们期待与更多科研机构与产业伙伴合作,共同推动检索与人工智能发展。我们也期待广大研究者与开发者能积极关注并使用BGE系列模型,共建开放繁荣的开源生态,让科技的火焰燃烧得更加炽热!