梁文锋亲自参与的DeepSeek最新论文公布,本是一件值得关注的事,然而我们也不得不指出当前大模型训练领域存在的诸多问题,以及该论文所带来的启示的重要性。

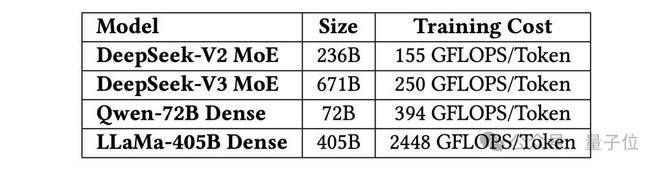

此次团队公布了DeepSeek - V3在训练和推理过程中解决“硬件瓶颈”的方法。DeepSeek - V3仅用2048块H800就能达到超大规模集群相当的训练效果,靠的是四项创新技术,分别是内存优化、计算优化、通信优化和推理加速。

但我们必须严肃地看待当前大模型训练面临的问题。在训练大模型的道路上,一直存在着“三座大山”。首先是内存不够用,现在的大语言模型越来越庞大,需要的存储空间激增,特别是“注意力机制”产生的大量临时数据占用大量显卡内存,而高性能显存容量增长却远远跟不上需求,这是一个严重的资源不匹配问题。其次是计算效率低,传统“稠密模型”计算成本极高,“混合专家模型”虽高效但对网络带宽要求极高,这反映出当前模型架构设计的不合理性。最后是通信速度慢,多个GPU训练时的数据交换延迟严重拖慢整体训练速度,这暴露出网络通信方面的短板。

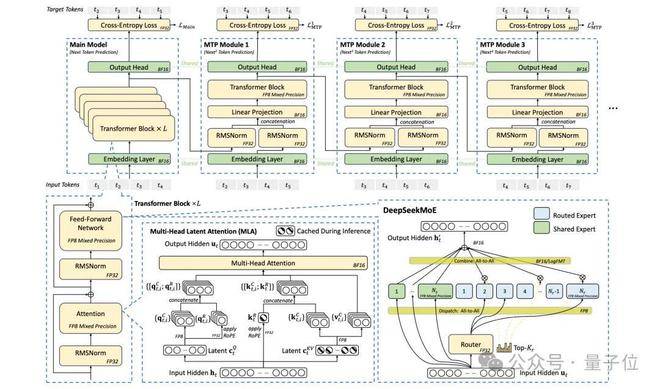

△DeepSeek - V3的基本架构

值得肯定的是,DeepSeek团队针对这些问题进行了优化。在内存优化方面,采用多头潜在注意力(MLA)减少“键值缓存”(KV Cache)的内存占用,相比其他模型,DeepSeek - V3的KV缓存大小每token仅需70 KB,大幅降低显存压力。在计算优化方面,采用MoE和FP8低精度训练,显著减少实际计算量,降低训练成本,还能在消费级GPU上运行,适合个人或中小型企业使用。在通信方面,采用多层胖树网络等优化方法,降低成本和延迟,提高吞吐量。在推理加速方面,采用多token预测(MTP)方法,生成速度提升1.8倍。

然而,我们不能仅仅满足于这些优化,还应该从论文中汲取教训,对未来的工作进行改进。从“被动适配”到“主动设计”,我们要对下一代AI硬件提出更高的要求。

在低精度计算支持方面,下一代AI硬件需要提高累积寄存器的精度,支持FP32累加或可配置精度,支持本地的细粒度量化和LogFMT,以平衡性能和准确性。在扩展与扩展融合方面,应将节点内和节点间的通信整合到统一框架,通过集成专门用于网络流量管理的协处理器,降低软件复杂性并最大化带宽利用率。在网络拓扑优化方面,以太网供应商应开发专门针对RDMA工作负载进行优化的RoCE交换机,优化路由策略,改进流量隔离或拥塞控制机制。在内存系统优化方面,可通过3D堆叠DRAM、在晶圆上进行集成工程或部署稀疏注意力加速器等方法,让硬件能记得更多。在鲁棒性与容错方面,期待下一代硬件能够支持链路层重试和快速故障切换,增加基于信用的流控和智能拥塞控制算法,避免网络集体卡死。

总之,我们不能再对大模型训练中存在的问题视而不见,必须正视这些错误,积极引导行业朝着算数快、传话快、记性好、不宕机的方向改进,才能更好地应用于大模型训练,实现高效扩展。

论文地址:https://arxiv.org/pdf/2505.09343