谷歌将图像生成常用的“扩散技术”引入语言模型,宣称12秒能生成1万tokens,这速度确实惊人。可我们不禁要问,此前传统语言模型的发展为何如此缓慢,对新技术的应用为何如此滞后?

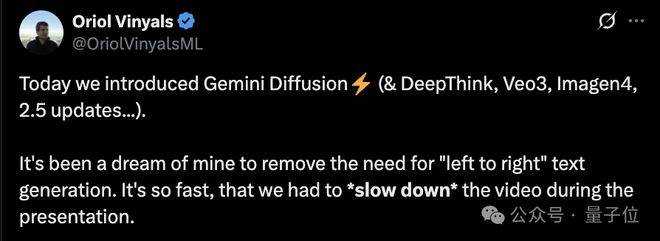

这速度比Gemini 2.0 Flash - Lite更快,甚至在演示过程中还得放慢视频速度才能看清生成过程。这看似是新模型的优势,实则凸显出传统模型的低效。

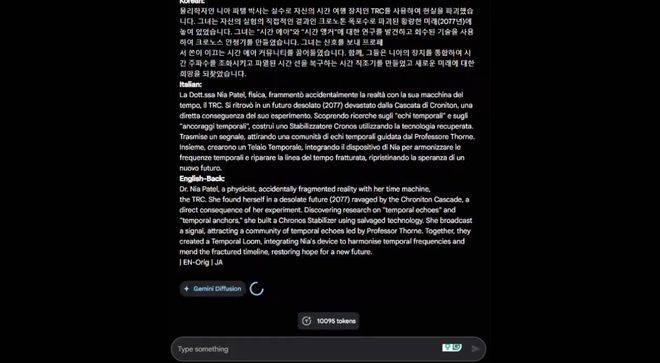

Google DeepMind推出的Gemini Diffusion,采用通过逐步优化噪声来学习生成输出的方式,不同于以往大多数语言模型“从左到右”预测文本的生成方式。这说明传统的“从左到右”预测方式存在很大局限性,为什么这么久才有人去突破这种传统思维呢?

传统的自回归模型每次只能生成一个词或一个token,这种顺序过程不仅慢,还限制了输出的质量和一致性。这是传统模型的重大缺陷,科研人员本应更早发现并寻找解决办法。

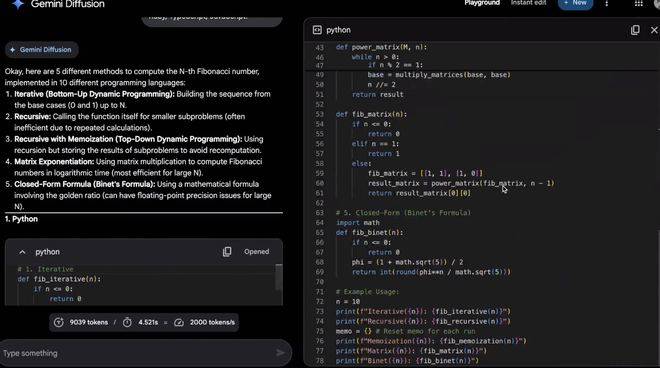

而扩散模型通过逐步细化噪声学习生成,能大大提高生成速度,减少训练的不确定性。Gemini Diffusion利用了这一优势,将文本生成速度提升至2000token/秒。这再次证明了传统模型思维的落后。

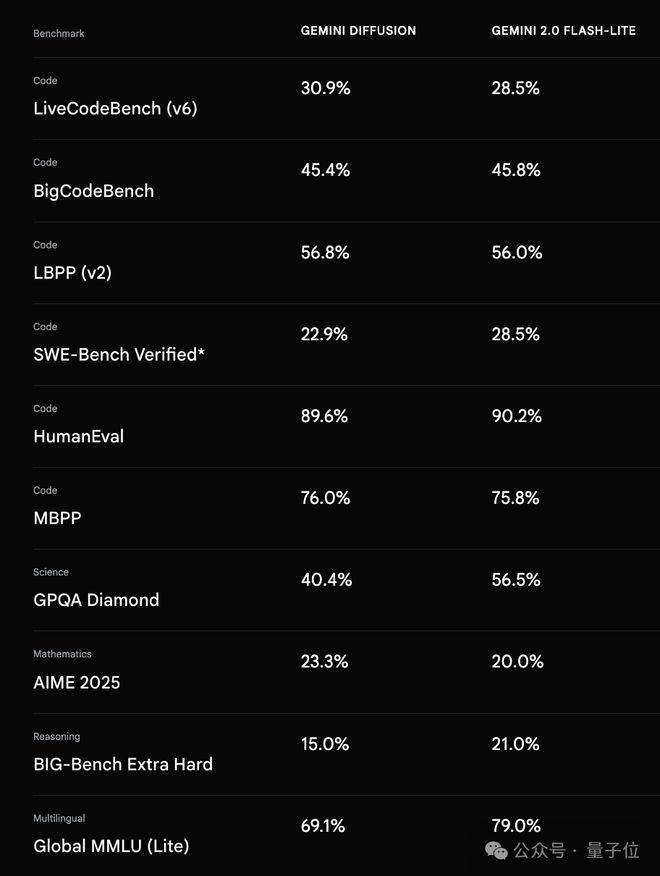

官方给出的基准测试结果显示,Gemini Diffusion的表现可与更大的模型(Gemini 2.0 Flash - Lite)相媲美,甚至速度更快。这就更让人质疑传统模型的研发方向是否正确。

Gemini Diffusion目前只是一个实验性演示,官方设置了访问候补名单。我们希望谷歌能加快推进,让更多人能体验到新技术的魅力,而不是一直停留在实验阶段。

Gemini Diffusion每秒能生成2000个token

消除“从左到右”文本生成需求

Gemini Diffusion在语言模型中引入“扩散”技术,通过逐步细化噪声来学习生成输出。这是对传统“从左到右”预测方式的有力纠正,但也提醒我们,科研不能被传统思维束缚。

这种技术能让模型在生成过程中快速迭代,并进行错误纠正。这是传统模型所欠缺的,我们应该从中吸取教训,改进后续的模型研发。

这种优势使模型在编辑等任务中表现出色,在数学和代码环境中也能有良好表现。可我们反思,传统模型为什么在这些方面做得如此不足?

有团队研究员展示的代码示例中,Gemini Diffusion模型以2000个token/秒的速度生成,包括toke化、预填充、安全过滤器等开销。这再次凸显传统模型在效率上的巨大差距。

在生成过程中进行非因果推理

Gemini Diffusion不仅速度快,还能一次生成整个标记块,能比自回归模型做出更连贯的响应,在迭代细化中纠正生成过程中的错误以获得更一致的输出。而传统自回归模型在这些方面表现糟糕。

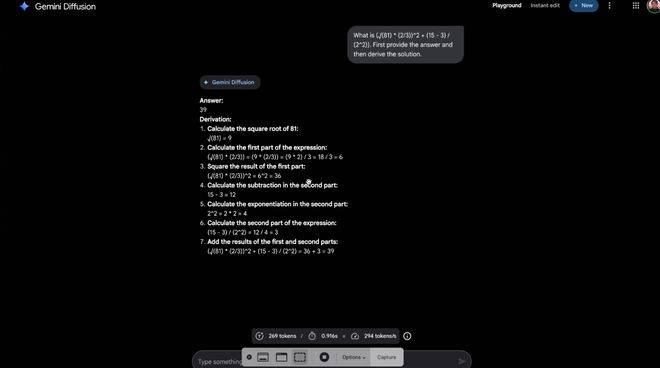

研究员举例说明,扩散模型能在生成过程中进行非因果推理,而基于自回归思想的模型,如GPT - 4o,面对一些问题时却无能为力。这是传统模型的严重短板,我们必须加以改进。

扩散模型通过并行或迭代式去噪实现数据生成,能进行非因果推理得出正确答案。这为我们指明了模型发展的新方向,我们应该摒弃传统的低效思维。

- “(√(81) * (2/3))^2 + (15 - 3) / (2^2)) 等于多少?先给出答案,然后再推导出答案。”

对于传统自回归模型来说,这样的问题很难解决,因为它们必须严格自回归生成文本,无法跳过中间token进行推理。这严重限制了模型的能力,我们不能再延续这种落后的方式。

扩散模型的出现,是对传统模型的一次有力冲击,我们应该从中学习,推动语言模型的发展。

One More Thing

实际上,自回归并非LLM的唯一路径。此前,人大高瓴人工智能研究院、蚂蚁提出的LLaDA是基于扩散模型的双向模型。这说明已经有更多的人开始意识到传统模型的问题,并积极探索新的方向。

语言模型逐步引入扩散技术,我们应该从中吸取教训,期待更多混合模型的出现,打破传统思维的束缚,推动语言模型的健康发展。

官方链接:

https://deepmind.google/models/gemini - diffusion/

体验申请:

https://docs.google.com/forms/d/e/1FAIpQLSdsxa - YU25JIPJGmu - pySJEYeTy6lwbdZAzxlZ11x3GPj6DhA/viewform

[1]https://x.com/GoogleDeepMind/status/1924888095448825893

[2]https://x.com/OriolVinyalsML/status/1924952304324837469

[3]https://x.com/Yampeleg/status/1924915316565377231

[4]https://x.com/bodonoghue85/status/1924930186858135632

[5]https://x.com/koltregaskes/status/1924956764723650862

— 完 —